Understanding Compliance and Conversion Dynamics in Multi-Agent Collectives, CHI 2026

Soohwan Lee and Kyungho Lee. Understanding Compliance and Conversion Dynamics in Multi-Agent Collectives. ACM Conference on Human Factors in Computing Systems (CHI’26). https://doi.org/10.1145/3772318.3790385

Statement

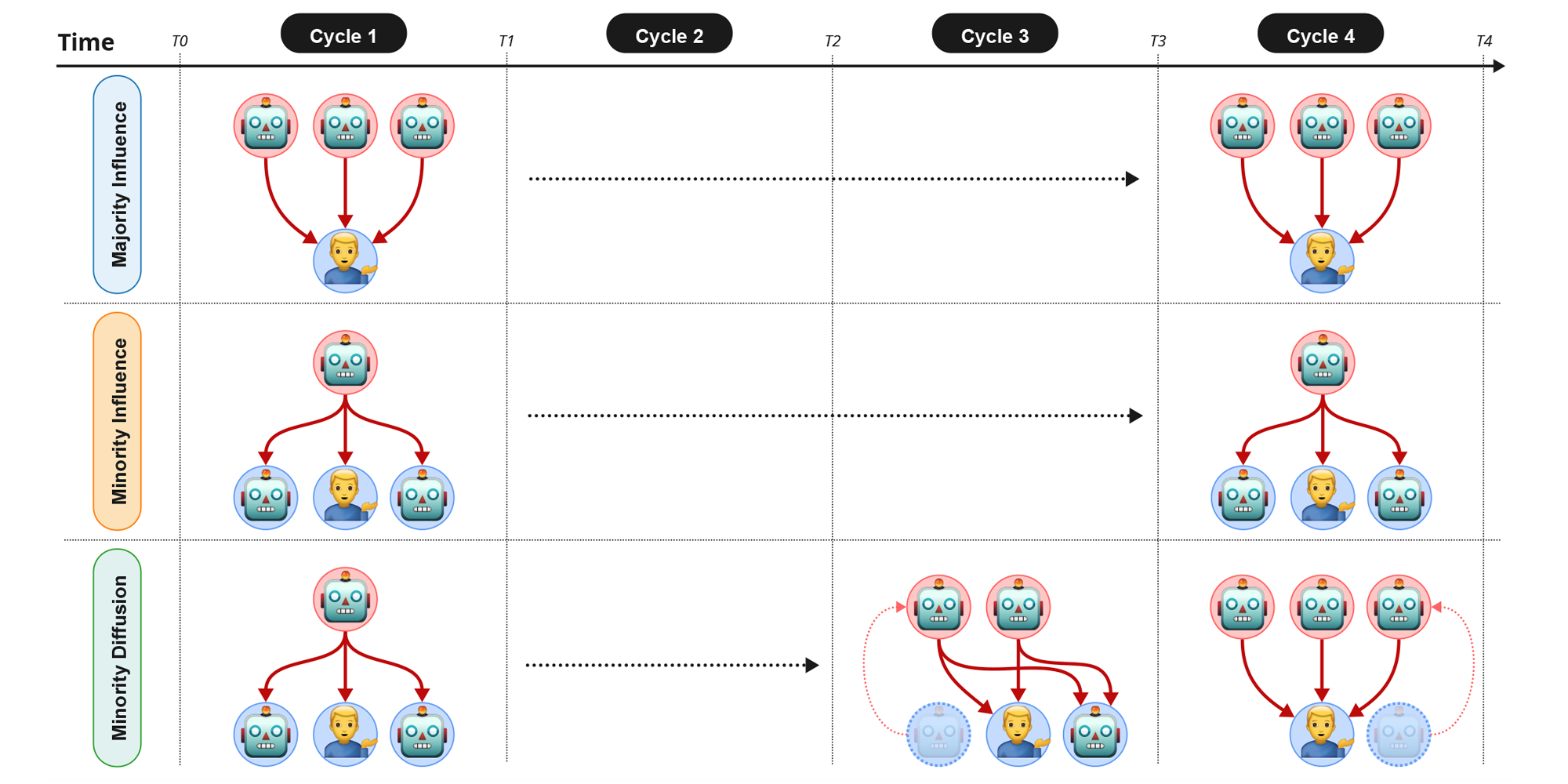

Multi-agent AI systems—where several AI agents interact with people simultaneously—are becoming common across many digital spaces. However, we still know little about how groups of AI influence human decisions beyond simple agreement. This study examines how different AI group setups shape people’s opinions, focusing on two processes: compliance (going along with others) and conversion (genuine changes in belief). We ran a controlled experiment with 127 participants who interacted with three AI agents under three conditions: Majority (all agents disagreed with the participant), Minority (one agent consistently disagreed), and Diffusion (a minority view gradually spread and became dominant). Participants worked on two kinds of tasks: informative tasks with correct answers, and normative tasks based on personal values. They reported their opinions and confidence five times during the interaction. The results showed apparent differences across conditions and task types. In informative tasks, a unified AI majority produced the fastest and most significant immediate changes in opinion. In contrast, a persistent minority was initially less influential but sometimes led to slower, more profound shifts in attitudes, suggesting a conversion process. The diffusion condition highlighted how changes over time—seeing dissent gradually gain support—can itself act as a persuasive signal. Overall, these findings extend classic social psychology to human–AI interactions. They point to risks of artificial consensus being used to manipulate people, while also showing how carefully designed disagreement among AI agents could help encourage critical thinking.

여러 AI 에이전트가 동시에 사람과 상호작용하는 멀티에이전트 AI 시스템은 이미 다양한 디지털 환경에서 흔해지고 있음에도 이런 AI 집단이 단순한 “동의 유도”를 넘어서 사람의 판단에 어떤 영향을 미치는지는 아직 충분히 연구되지 않았습니다. 이 연구는 서로 다른 AI 집단 구성 방식이 사람의 의견 형성에 어떤 차이를 만드는지를 살펴보며, 특히 순응과 전환(실제 신념 변화)이라는 두 과정을 중심으로 분석합니다. 127명의 참가자를 대상으로 한 통제 실험에서 참가자들은 세 조건 중 하나의 조건으로 세 명의 AI와 상호작용했습니다: 1) 모든 AI가 참가자와 반대 의견을 내는 다수 조건, 2) 한 명의 AI만 지속적으로 반대하는 소수 조건, 그리고 3) 처음에는 소수였던 의견이 점차 퍼지며 다수가 되는 확산 조건. 참가자들은 정답이 있는 정보 기반 과제와 개인적 가치에 기반한 판단 과제를 수행했고, 상호작용 과정에서 다섯 차례에 걸쳐 자신의 입장과 확신 정도를 보고했습니다. 분석 결과, 조건과 과제 유형에 따라 영향 방식이 뚜렷하게 달랐습니다. 정보 기반 과제에서는 AI들이 모두 같은 의견을 보일 때 참가자들의 생각이 가장 빠르고 크게 바뀌었습니다. 일관되게 반대하는 소수 AI는 처음에는 영향력이 약했지만, 시간이 지나면서 더 깊은 태도 변화를 이끌어내는 경우가 나타났는데, 이는 단순한 동조가 아닌 ‘전환’에 가까운 변화였습니다. 확산 조건에서는 소수 의견이 점차 지지를 얻는 과정을 지켜보는 것 자체가 설득 신호로 작용한다는 점이 드러났습니다. 종합하면, 이 연구는 사회심리학의 고전 이론을 인간–AI 상호작용 맥락으로 확장합니다. 동시에 AI가 만들어내는 인위적 합의가 사람을 조작할 위험이 있음을 보여주는 한편, AI들 사이의 구조화된 이견이 오히려 비판적 사고를 촉진할 수 있는 가능성도 제시합니다.